【re:Invent2024参加レポート】カスタムシリコンチップについて

はじめに

今回は、Matt Garman氏のkeynote(基調講演)について触れます。

AWS re:Inventでは、生成AIが大きく取り扱われました。(生成AIも含めて、100以上の新サービスが発表されました)

事前の予想でも生成AIについて多くの発表があると予想されていたようですが、keynoteの開始はEC2からでした。

keynote当日の夜に開催された、Japan Nightという催しで、AWS ジャパンの社長の白幡氏もこぼしておりました。

「EC2から始まるとは思わなかったですよね? 私も驚きました。」

という主旨のことを触れておられたのが印象的です。

シリコンチップについて

EC2から始まった流れで最終的にはAIについての多くの発表につながっていったわけですが、その中で私が特に印象に残ったのは、シリコンチップについてです。

Arm CPUの「Graviton」については2018年の発表から利用されてきており、GPUについても進化していくのは自明だったかもしれません。

そう、私が興味深いと思ったのは、生成AIや機械学習のトレーニングに最適化した独自プロセッサの「AWS Trainium3」のことです。

Trainium3って何?

AWSはCPUのGraviton、AI推論向けの「Inferentia」、そしてAI学習向けの「Trainium」とシリコンチップを投入しています。

クラウドサービスというユーザが利用するサービスの提供から始まって、直接ユーザが触れることのない物理的な層を提供していくというのは新鮮です。

というのも、いわゆるレガシーとされるホストや各社が独自にカスタマイズしたUNIX系OSといった、物理的なハードウェアからOS、そしてその上にのるユーザが利用するサービスを提供していくというビジネスモデルは、すでに減少していっていることは明らかです。

※オンプレミス回帰の動きもありますが、新しく物理的なハードウェアからOS層まで新しく作り上げていくということは当面はないものと思います。

※あるとすればそれは量子コンピュータの世界かもしれませんが、本筋から外れるので割愛します。

AWSはその逆でユーザが利用するために必要となってくるであろう、物理的なハードウェアの提供まで、いうなれば上から下に向かってビジネスを進めているように感じられて、その点がとても面白いと感じました。

おわりに

シリコンチップ以外にも「Amazon S3 Tables」や「Amazon S3 Metadata」といったストレージについての発表や、「Amazon Aurora DSQL」も興味深かったです。

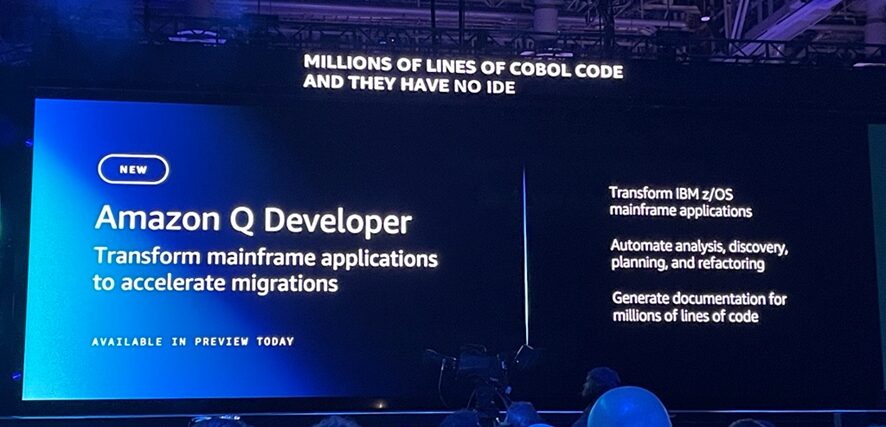

ただやはりメインは、「Amazon Bedrock」や「Amazon Q」、「Amazon SageMaker」などのAI基盤やそれを利用した各種の新サービスであったかと思います。そういった部分については別記事で触れているため、そちらもご覧になっていただけると幸いです。